Van gedoe naar 100% controle: Hoe iedere IT-manager vanaf nu problemen sneller oplost en nieuwe problemen voorkomt

GPS is best nauwkeurig toch? Nou, dat valt best tegen. Als mijn vrouw en ik een wandeling maken dan geven onze smartwatches – van verschillende merken - verschillende afstanden aan die we gelopen hebben. Andere merken meten anders kennelijk. En dat verschil is veel groter dan de een die binnenbochten loopt en de ander die buitenbochten loopt. Het scheelt soms wel 10%.

Nou is dat bij een wandeling nog te overzien, maar voor mijn hardloop-training wil ik toch wel nauwkeuriger dan 10% weten hoe ver ik gelopen heb. En niet dat als het horloge 5km aangeeft dat het ergens tussen 4,5 en 5,5 km is. Dat verschil vind ik echt te groot. En voor een topsporter is zo'n afwijking natuurlijk onaanvaardbaar. Oh ja, we hebben het hier niet over goedkope smartwatches ..

Het probleem van fouten in nauwkeurigheid gaat veel verder dan de meeste mensen vermoeden. Mijn voorbeeld hierboven gaat ‘slechts’ over wandelen en hardlopen. Maar wat als ik je vertel dat dit fenomeen een organisatie dagelijks tienduizenden euro’s kan kosten?

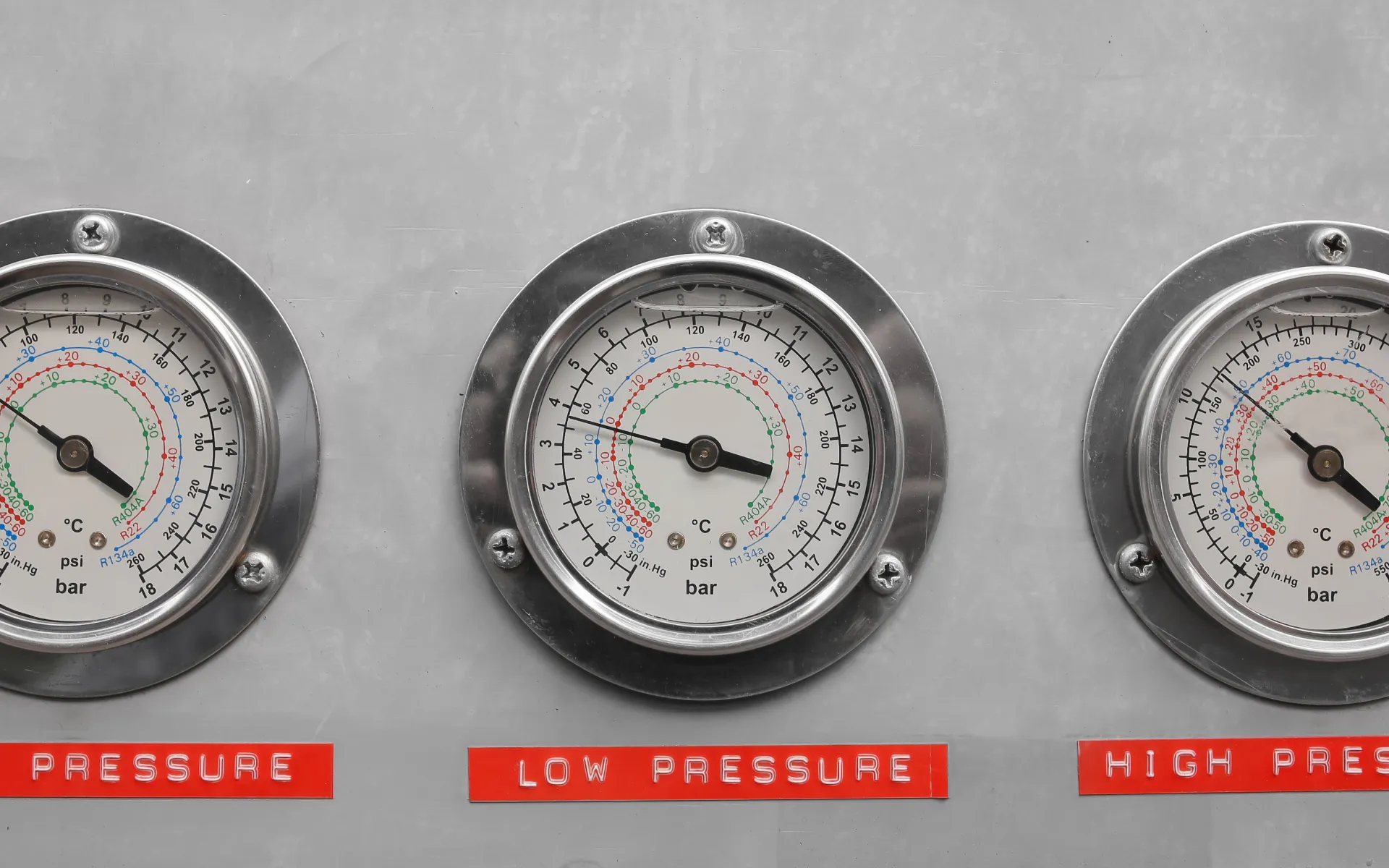

Het misplaatste vertrouwen in metertjes .. Hoe vaak en wanneer meet je?

Veel smartwatches slaan je positie elke 10 seconden op. Staan we niet bij stil (zeker niet tijdens het (hard)lopen ;) maar dit is de realiteit. Waarop we massaal vertrouwen. Als die systeempjes vaker opslaan dan passen er veel minder activiteiten in het geheugen. Als je een bocht loopt die je 20 seconden kost en je positie wordt opgeslagen aan het begin, het midden en het eind van de bocht dan is de gemeten afstand 10% te kort. De meting snijdt, letterlijk, de bocht af terwijl jij de hele bocht loopt. Minder vaak meten maakt de meting behoorlijk onnauwkeurig.

Een zelfde fenomeen vindt plaats in iedere organisatie, iedere minuut van de dag. En dat kost organisaties veel geld, zonder dat iemand het in de gaten heeft. Want we vertrouwen op onze metertjes. Iets wat ik ook doe, want he, we willen toch geen uit de bocht vliegende control-freak zijn die alles wil controleren. Ehhh .. wel dus. Wel wanneer dit een ongemerkt hoge impact op budgetten en daarmee winstgevendheid (!) van organisaties betreft.

Ik noem dit het misplaatste vertrouwen in metertjes; ik weet het, het is niet ‘sexy’ noch populair om dit te stellen maar het is de realiteit.

Leuk Hugo, maar wat heeft dit met het oplossen en voorkomen van IT-problemen te maken?

Nou, alles dus. Want dat meten per 10 seconden, dat doet het meeste Application Performance Management (APM) tooling ook. En daardoor kun je met dat soort tooling niet goed meten wat er in je applicatie ketens en infrastructuur gebeurt. Laat dat even op je inwerken: je hebt dus software in huis waar je op vertrouwt maar ondertussen is er zoveel onnauwkeurigheid dat het je waarschijnlijk bakken met geld kost.

Die onnauwkeurigheid kan de echte problemen niet goed opsporen en ook problemen niet op tijd melden, laat staan voorkomen. Vergelijk het met een brandmelder die ieder kwartier checkt of er rook is. Zo werkt de meeste APM-tooling ook. En daardoor doen die tools vaak niet waarvoor ze bedoeld zijn.

Een voorbeeld: Iemand die met dergelijke tooling werkt vroeg me eens "maar als we elke 10 seconden meten, wat kunnen we dan missen?". Dan mis je bijna alles. Het ging om de meting van een grote e-commerce site. Op zo'n webshop mag een pagina hooguit 3 seconden duren, en voor millennials 2. Anders zijn ze naar de concurrent. Dat betekent dat de langzaamste componenten waaruit zo'n pagina is opgebouwd maximaal 0,5 seconde mogen duren. En als je elke 10 seconden componenten meet die 0,5 seconden duren dan zie je maar 5% van die componenten in de meting. Je mist 95% van wat er aan de hand is. Bovendien zie van die 5% maar een momentopname, en niet de hele component. Je ziet dus wel iets, maar je meetdata is van abominabel slechte kwaliteit. Daardoor mis je de oorzaken van te trage responstijden en zie je het niet op tijd aankomen als de responstijden flink oplopen.

Je kunt in veel APM tooling wel de meetfrequentie naar 1 seconde zetten, maar dan zie je nog maar de helft van de 0,5 seconde componenten en van de helft die je ziet zie je maar weer een momentopname. Bovendien gaat de meting zo veel CPU en geheugen gebruiken dat de meting zelf een verstoring wordt. En de kosten van het opslaan en analyseren van 10 keer zo veel meetdata daar wordt je ook niet blij van.

Voor in huis en cloud applicaties kijken we naar verloren werktijd en te hoge IT- en cloudkosten in plaats van naar verloren conversie, maar daar wordt dit verhaal niet echt anders van. Als je elke 10 seconden kijkt zie je nog steeds niet uit welke hoek de klappen komen, en vaak niet eens op tijd dat er een klap komt.

Een hele nieuwe manier van meten, 100% nauwkeurig

Jaren geleden liep ik voor het eerst tegen problematiek aan dat we verrast werden door gedoe en serieuze problemen waarvan we verwachtten dat de tooling die op tijd zouden melden. Ik kan diverse verhalen vertellen uit die tijd die allemaal neerkomen op:

- Onze klanten werden verrast door plotselinge problemen

- De tooling was niet in staat oorzaken te ontdekken of oplossingen te definiëren, alles stond op 'groen'

- Oplossen ging alleen met tijdrovend handwerk, waardoor problemen veel te lang bleven bestaan

Uiteraard doken we in de systemen op zoek naar de oorzaak van de ontstane ellende. Eerst moest alles opgelost worden. Om vervolgens een antwoord op deze vraag te krijgen: hoe kon het dat we dit gemist hebben? Dat was mijn uitdaging.

Door hier naar op zoek te gaan kwam ik erachter hoe het zit met nauwkeurigheid. Dat bleek het probleem. De oplossing moest gezocht worden in het afscheid nemen van die 10-seconden regel. En dat leidde tot een hele nieuwe manier van meten die veel sneller veel meer inzicht geeft.

Bij Sciante meten we voor onze klanten volcontinu en zien wij en onze klanten 100% van wat er gebeurt. Dat is de kracht van onze unieke meetmethode. De onvrede over de slechte data kwaliteit van bestaande tooling werd uiteindelijk één van de redenen waarom ik Sciante opgericht heb. Mijn missie was, is en blijft: optimalisatie van IT. Er is ontzettend veel te winnen in IT-optimalisatie en dat begint met nauwkeurig meten. Nauwkeurig betekent bij ons dat je naast dat je 100% vertrouwen in de data hebt, je ook 100% nauwkeurige resultaten krijgt. En dat zorgt ervoor dat problemen sneller opgelost worden en belangrijker nog, voorkomen worden.

Dat het werkt hebben we in de afgelopen 14 jaar laten zien. We hebben diverse opdrachten gedaan waar allerlei tooling en diensten al ingezet waren die geen oorzaken vonden. Wanneer wij erbij gehaald worden vinden we elke keer pijlsnel alle oorzaken van problemen. Ons record is 15 minuten …

Niet alleen oplossen, juist ook voorkomen

Als de vlammen uit het dak slaan weet iedereen wel waar de brand is, dan zie je de rook op kilometers afstand. Al is het blussen dan nog best specialistenwerk. Maar dat geeft zoveel schade, dat wil je echt voorkomen. Om kleine brandjes en zelfs het eerste gesmeul in de kiem te smoren moet je weten dat er wat aan de hand is, en in de IT betekent dat dat je 100% nauwkeurig moet meten.

Om die virtuele brandschade te voorkomen maak je een vrijblijvende afspraak met mij, dan bespreken we welke risico's je loopt en bepalen we samen hoe je die risico's het beste af kan dekken.

Hugo Van den Berg

alias Mr Optimize